Post anterior

Creación de buyer persona orientado a arquitectura webEstar en Internet ya no es suficiente. Que te encuentren, sí. Eso marca la diferencia.

Hoy en día cualquiera puede tener una web. Lo difícil es que aparezca cuando alguien realmente busca lo que tú ofreces. Y para eso, no vale solo con que sea bonita: necesitas visibilidad orgánica real, de la que trae resultados.

El tráfico orgánico de calidad —ese que llega sin pagar por clic y con ganas de comprar, reservar o preguntar— sigue siendo uno de los activos más rentables que puedes tener. Pero no aparece por arte de magia.

Se consigue con un SEO técnico bien hecho, donde el rastreo, la indexación y una arquitectura clara de la información permiten a Google entender y mostrar tu web justo cuando debe. Sin esto, por muy buena que sea tu oferta, nadie la verá.

Rastreo: cómo hacer que Google no pierda el tiempo en tu web

Cuando un bot (como Googlebot) entra en tu web, no lo hace con tiempo infinito ni con paciencia eterna. Tiene un “presupuesto de rastreo” limitado, lo que en el mundillo se llama crawl budget. Y si lo malgasta en páginas sin valor, errores o contenido duplicado… mal asunto.

¿De qué depende ese presupuesto? De varios factores:

- Autoridad del dominio: Cuanto más confiable seas para Google, más veces pasará por tu web.

- Actualización del contenido: Si ve que publicas o cambias cosas con frecuencia, volverá más a menudo.

- Tiempo de respuesta del servidor: Si tu web va lenta, el bot se aburre (literal) y se va antes.

- Errores de rastreo: Cuantos más encuentre, menos ganas tendrá de seguir.

- Eficiencia de la arquitectura web: Si todo está a más de 4 clics, con enlaces rotos o sin lógica interna, el rastreo se vuelve un laberinto. Canonicals mal puestos, enlaces internos rotos o contenidos huérfanos también le complican la vida.

👉 ¿La clave? Ayudarle a encontrar lo bueno, rápido. Así invierte su tiempo en lo que realmente quieres posicionar.

Casos de uso actuales:

Páginas con IA generativa: si usas contenido generado con IA, asegúrate de que tenga valor real y no lo bloquees por defecto. Google puede rastrear, pero no siempre indexar.

Webs con filtros y paginaciones infinitas: prioriza el uso de parámetros controlados con robots.txt y la herramienta de parámetros de URL en Search Console.

Cargas dinámicas o JS pesado: rastrea con Mobile-First, pero si tu JS impide renderizado, Googlebot puede ignorar partes clave del contenido.

Indexación: ¿qué decide Google para guardar (o no) una URL?

Que una URL sea rastreada no significa que vaya a salir en Google. Para que eso ocurra, tiene que indexarla, es decir, decidir que merece estar en su “archivo público” de resultados.

Entonces… ¿cuándo la guarda y cuándo no? Aquí van algunos casos reales que me encuentro a menudo:

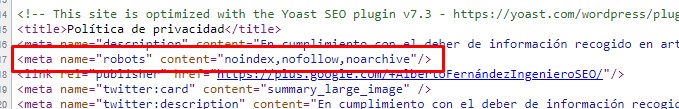

- URLs con noindex en el header

Aunque Google pueda entrar y leer la página, si le dices “no me indexes”, obedecerá. El problema es que mientras la rastrea, está gastando presupuesto sin beneficio. Y eso, si pasa a menudo, te puede penalizar a nivel de eficiencia. - URLs bloqueadas por robots.txt

Se supone que Google no debería ni entrar… pero si otras webs apuntan a esa URL, puede que la indexe igual. ¿El resultado? Aparece en Google… pero sin contenido. Solo la URL pelada. - Canonical mal puesto o forzado

Si le dices a Google “esta página no es la buena, la buena es esta otra” (aunque no lo sea), es probable que te haga caso… y se cargue la que realmente querías posicionar. No es magia, es lógica algorítmica.

👉 En resumen: La indexación es una decisión de Google basada en múltiples señales. Tu trabajo es dejarle todo claro, sin contradicciones, y evitar que desperdicie su tiempo.

Cómo usar el noindex sin liarla

El noindex le dice a Google: “oye, esta página no quiero que la muestres en los resultados”. Simple. Pero mal usado, puede hacer más daño que beneficio.

Hoy en día sigue funcionando igual de bien desde la etiqueta meta como desde la cabecera HTTP (X-Robots-Tag). ¿Cuál usar? Depende de tu web y de tu control técnico.

Aún después de colocar la etiqueta en el código HTML, la página puede seguir apareciendo en las búsquedas por tres razones.

- Puede que el buscador no haya interpretado la directiva adecuadamente, algo que puede ocurrir en algunos rastreadores.

- Puede que el bot no haya rastreado el cambio. Recuerda que las arañas pasan por las páginas cada cierto tiempo. Si deseas que el bot detecte la etiqueta con mayor rapidez, puedes solicitar un nuevo rastreo de tu página desde el buscador que te interese. Por ejemplo en Google desde aquí: https://www.google.com/webmasters/tools/submit-url

- Puede que hayas bloqueado la URL para los rastreadores mediante el archivo robots.txt. En este caso, para desbloquear los buscadores solo tendrás que modificar el archivo que habitualmente se encuentra en la raíz de tu servidor.

Si decides emplear la cabecera de respuesta HTTP para el uso de la etiqueta Noindex, solo tienes que volver a la cabecera X- Robots- Tag y colocar en tu respuesta los valores Noindex o None. Es decir, escribir X- Robots- Tag: noindex o X- Robots- Tag: none.

Sea cual sea la opción que elijas, debes asegurarte de emplearla de manera adecuada para no afectar tus resultados. Si no controlas las metaetiquetas se generarán errores de indexado y perderás todo el posicionamiento que que pueda conseguir tu sitio web.

Novedades 2025 que deberías tener en cuenta:

- Puedes meter un noindex con JavaScript, incluso usando Google Tag Manager. Y sí, Google lo interpreta… siempre que lo renderice bien.

- En webs más complejas, tipo headless CMS o SPA, es más seguro tirar de X-Robots-Tag desde backend: llega antes, se respeta mejor y es más fiable.

Cuidado con esto:

Nunca combines noindex con Disallow en el robots.txt.

Si bloqueas el acceso desde robots, Google no podrá leer el noindex, y entonces… sorpresa: esa URL podría acabar indexada igualmente.

En definitiva, noindex es útil, pero no perdona errores. Elige bien el método, no bloquees lo que quieres desindexar… y si puedes, haz pruebas antes de aplicarlo a lo loco.

Curiosidades de la meta robots (actualizadas)

- Existen más directivas a declarar de las que sueles usar (pero se usan mucho menos): index/noindex, follow/nofollow, archive/noarchive, translate/notranslate, imageindex/noimageindex, “unavailable_after: {fecha en formato RFC-850}”, snippet/nosnippet, none, odp/noodp y ydir/noydir

- noindex,nofollow: no indexar ni seguir los enlaces

- index,nofollow: indexar pero no traspasar autoridad a sus enlaces

- noindex,follow: no indexar pero que las arañas tomen en consideración los enlaces

- Es probable que la etiqueta meta robots (o al menos parte de sus directrices) no sea necesaria en la mayor parte de tus páginas. Si no ponemos nada, se sobre entiende index,follow

- NoIndex se encarga de la indexación no del rastreo.

- Pero noindex si afecta al rastreo: Lo disminuye.

- Pensemos un poco: ¿Y para que quieres poner un nofollow en tu web? ¿sirve de algo?

- Existe la posibilidad de declarar exactamente a que robot nos dirigimos en la etiqueta meta y actuar por separado para cada uno de ellos

- Cuando mezclas noindex con otras directrices en el html (canonical, rel=”prev/next”, etc) las cosas no funcionan como esperarías

- ¡Cuidado! Google lee el meta-robots en cualquier parte de la página, no solo en el <head> de la página

- Google lee y obedece a las etiquetas que creamos en el HTML por javascript y por lo tanto podemos incluirlas vía GTM

- También podemos enviar las directrices de meta-robots desde las cabeceras de la página

- Noindex no impide el rastreo, pero sí lo reduce a medio plazo.

- Google ignora etiquetas como noodp y noydir, ya que dejaron de usarse.

- X-Robots-Tag permite directivas por tipo de archivo (útil en PDFs o DOCs).

- El crawl-delay es ignorado por Google, pero puede funcionar con Bing o Yandex.

- Puedes usar unavailable_after: [fecha] para caducar contenidos automáticamente (ideal para campañas con caducidad).

Utilizar robots.txt

Con este fichero tenemos la capacidad de indicar a los buscadores qué URLs deben visitar y cuáles les recomendamos que no visiten. Trabajar este fichero es básico en cualquier proceso de indexación dentro de una consultoría SEO básica.

Debemos ser muy cuidadosos al utilizar este archivo, ya que se encuentra íntimamente relacionado con el acceso de las arañas a nuestro sitio. Si no se programa con atención, podríamos conseguir que perdieran el tiempo que nos tienen predestinado en páginas y contenidos que pudieran no ser relevantes y no interesarnos que los visitaran.

¿Cómo funciona el robots.txt? Su uso habitual parte de que todo robot puede visitarlo antes de rastrear cualquier URL y ver qué contenidos el webmaster ha indicado que deben interesarle y cuáles no. Por lo general los bots suelen hacer caso a las indicaciones, aunque si analizas los logs te darás cuenta de que en algunas ocasiones, hacen caso omiso. Ten en cuenta que el protocolo de robots.txt no garantiza un total hermetismo, así que no se aconseja su uso para la privatización total de ciertas áreas. Una forma de verlo más claramente es como una recomendación, en lugar de como una obligación.

El primer paso para crear el archivo es tener acceso a la raíz del dominio. Luego, debe subirse este fichero al directorio raíz de primer nivel del servidor, en formato de texto con el nombre “robots.txt”.

Una vez que el archivo se encuentre enlazado con el sitio, se debe introducir el texto y marcar cuáles son la partes a las que se desea dar acceso y a cuáles no. Finalmente, para comprobar el funcionamiento del archivo “robots.txt” puedes utilizar herramientas gratuitas como el probador de robots.txt que tenemos disponible entre las herramientas que Google pone a nuestra disposición en Search Console. Estas te mostrarán los posibles errores que el archivo tiene o puede ocasionar.

https://www.google.com/webmasters/tools/robots-testing-tool?hl=es&siteUrl=miurl

Buenas prácticas actualizadas:

- Usa robots.txt para limitar el rastreo de zonas sin valor SEO: carritos, filtros, sesiones, etc.

- No lo uses para bloquear contenido confidencial. Usa autenticación o cabeceras HTTP.

- Añade siempre la URL del sitemap: Sitemap: https://tudominio.com/sitemap.xml

Casos de uso:

- Bloquear parámetros innecesarios (Disallow: /*?ordenar=)

- Bloquear resultados de búsqueda internos (Disallow: /buscar/)

- Dejar pasar contenido clave como CSS y JS (Allow: *.css, Allow: *.js)

Curiosidades del fichero robots.txt

Me gustaría hacer eco del artículo de Iñaki huerta sobre algunas cuestiones que deberíamos saber sobre este fichero, ya que es importante tenerlas en cuenta:

- El formato es relevante y sencillo, pero debemos utilizar los comandos adecuados en cada caso: user-agent, disallow, allow, sitemap…

- La colocación del archivo es importante, dado que en función de la carpeta del servidor donde lo coloques afectará o no a otros subdominios. Además, Google solo lee el fichero si está en la raíz del documento. Esto “midominio.com/blog/robots.txt” no serviría de nada.

- Cuidado con el tamaño de archivo, Google nos lo limita a 500MB, y el tipo. Evita caracteres extraños que pueda devolver tu servidor usando la codificación UTF-8. Utiliza editores como Notepad++ para trabajarlo.

- Disallow no sirve para evitar la indexación, solo prohibe leer el contenido aunque a la larga puede implicar la desindexación, a la larga. No funciona igual que el noindex, aunque sí economiza rastreo, dado que noindex necesita que el bot acceda a la URL a leerlo, y desde el robots.txt no necesita acceder a ella.

- Si el contenido no se lee, las directivas HTML se ignoran. No tiene sentido usar Disallow+noindex o Disallow+canonical o Disallow+rel-next/prev o Disallow+loquesea-en-el-html. Si le prohibimos acceder, ¿para que trabajar el etiquetado en esa URL?

- La redacción de las URLs es simple, pero muy concreta y a veces las reglas de lectura no son tan intuitivas como podría parecer.

- Para evitar el rastreo o la indexación hay otras alternativas al robots.txt o meta-robots, pero no son igual de potentes. La herramienta de borrar contenido de Google a los 90 días podría volver a indexarla si la encuentra, y la herramienta de parámetros de URL que también tenemos en Search Console solo sirve de ayuda como pudiera ser el Sitemap pero si Google considera esos parámetros interesantes, los usará de igual modo le pongas lo que le pongas.

- Todas las directivas que no se contemplen en la definición de nuestro fichero robots se ignoran. Por ejemplo, algunos servidores colocan por defecto una sentencia “Crawl-delay” que directamente Google ignora, aunque otros sí la respetan. Para escribir comentarios, comenzaremos las líneas por #

- ¿Qué pasa cuando Google no puede acceder o encuentra cosas raras al acceder a tu archivo robots? Si Google no encuentra el fichero en su lugar habitual, podría ir a buscarlo a un nivel superior de dominio, por ejemplo si no está en www.midominio.com/robots.txt lo iría a buscar a midominio.com/robots.txt.

- Si el fichero tiene código 200, entrará y seguirá sus instrucciones, y si está vacío verá la web completa.

- Ante un código 4xx, lo tomará como si estuviera vacío, y accederá a todo el site.

- Ante un 3xx, tomará la URL de referencia como el auténtico fichero, incluso aunque no se llame robots.txt. Con esta última premisa, cuidado al realizar una migración si deseamos seguir bloqueando URLs del site antiguo no debemos redireccionar el fichero robots.txt.

- Otros códigos como el 503, sobre el cuál Google consultará hasta que el estado cambie. Ahora bien, si dejamos esto demasiado tiempo, podrían empezar a perder fuerza los enlaces, por lo que no se recomienda tenerlo así más de unas horas. No se sabe por qué, pero podemos sufrir pérdidas de autoridad e intentos de reindexar la web.

- Sin respuesta. Si el servidor no devuelve nada o tarda demasiado por saturación, Google tira de la caché que tiene de ese fichero durante un tiempo.

- Bloquear CSS y JS puede ocasionar problemas y está mal visto por el buscador.

- Google entra en contenidos 4xx pero no si se le bloquea. Es mejor marcarlas con Disallow y evitar tener links hacia ellas en el HTML.

- Es posible enviar un noindex desde tu servidor creando una especie de robots.txt pero para noindex y nofollow. Te invito a visitar su web en el enlace que hay en referencias dado que este punto es sumamente interesante.

Con toda esta información seguro que ahora entiendes un poco más sobre cómo organizar de forma adecuada un sitio web. Lograr la popularidad que buscas es posible, solo necesitas seguir procesos que ya han sido estructurados. Con el asesoramiento profesional adecuado podrás lograrlo sin mayores inconvenientes.

Emplea estas herramientas adecuadamente y consigue la estructura adecuada para tu sitio web. Esto le permitirá a los usuarios que visiten tu sitio encontrar el contenido de forma intuitiva y logrará que los rastreadores indexen la información correcta.

Errores comunes que siguen ocurriendo en 2025

- Bloquear CSS/JS y luego quejarse de mala indexación (afecta a CWV y al contenido visible).

- Poner

Disallow: /wp-admin/sin permitir eladmin-ajax.php, rompiendo funcionalidades básicas de WP. - Usar canonical + noindex juntos: Google puede decidir ignorar ambos o elegir lo contrario a lo que tú quieres.

- Enviar sitemaps de URLs que están bloqueadas en robots.txt (¡incongruente!).

¿Y qué pasa con IA y rastreo?

- Google está usando IA (Search Generative Experience) para generar snippets extendidos. Asegúrate de no bloquear

Google-Extendedsi quieres aparecer en esa capa de búsqueda. - Para evitar el uso en IA generativa, añade al header:

User-agent: Google-Extended

Disallow: /

Herramientas recomendadas

- Inspect URL – Ver estado de indexación

- Visualización de rastreo con Screaming Frog

- Logs de servidor + análisis con Log File Analyzer

Conclusión: controla tu rastreo, gana visibilidad

Una arquitectura bien diseñada, un control estratégico del rastreo y directivas bien configuradas son fundamentales para escalar en SEO técnico. No dejes tu indexación al azar.

Combina robots.txt, meta robots, X-Robots-Tag, canonicals, sitemap y enlaces internos para decirle a Google qué debe ver, qué debe ignorar y cómo debe interpretar tu web.

Y si tienes dudas, ya sabes que siempre puedes contar con un experto SEO que haya lidiado con arañas más veces que un exterminador.

Referencias

- https://support.google.com/webmasters/answer/7645831?hl=es

- https://www.google.com/search/howsearchworks/

- https://support.google.com/webmasters/answer/6062608?hl=es

- http://blog.ikhuerta.com/101-cosas-que-deberias-saber-sobre-los-archivos-robots-txt-e-indexacion-seo

- http://blog.ikhuerta.com/10-cosas-que-deberias-saber-sobre-las-etiquetas-meta-robots-noindex-nofollow-e-indexacion