Post anterior

Estrategia SEO: el salto de la ranaNo sé vosotros, pero para mí la indexación es fundamental en el trabajo de posicionamiento en buscadores, y básico en cualquier estrategia SEO.

Si una URL no está indexada, jamás vamos a poder posicionar ni rankear por nada.

¿Qué significa indexación?

Para poder trabajar con Google, es importante saber cómo funcionan sus robots y el buscador en general. No sé si sabéis que cuando alguno de sus robots llega a una página nueva, la encuentra, añade esa URL a una lista junto a otras páginas rastreadas de la misma categoría.

En esta URL de la ayuda de Google lo indica: https://support.google.com/programmable-search/answer/4513925?hl=es

En resumidas cuentas: Google descubre URLs, sus robots las crawlean y si cumple ciertos requisitos, las indexan.

Una buena indexación es la base del SEO

Como toda gestión documental, existe un orden interno dentro de Google: categorías, índices, palabras, referencias… de modo que sea más sencillo encontrar exactamente lo que estemos buscando. El buscador contiene un índice de páginas clasificadas de diversas formas. Estas páginas no son exactamente las URLs de las páginas web, sino una captura de pantalla de las páginas según fueron vistas en el último rastreo. Es lo que conocemos como caché de páginas.

Para conocer la caché de una URL usaremos el siguiente comando en el buscador

cache:www.albertofdez.com

La caché puede no ser idéntica a la URL en tiempo real, por ejemplo si ha cambiado recientemente. Si Google detecta esto a menudo, hará que cada vez pase con más frecuencia por tu sitio web. Su interés es devolver siempre una última versión válida en los resultados de búsqueda. Por ello es tan importante nutrirle constantemente de contenido, preferiblemente de calidad.

Y hay que señalar, un sitio rápido con un buen trabajo de WPO (Web Performance Optimization) será un sitio mejor capacitado para ser recorrido e indexado por los robots.

Aquí, antes de seguir leyendo, vamos a ver este video que aunque es un poco antiguo, pero nunca está demás escuchar lo que dice Google al respecto.

¿Qué es eso del crawling?

Los robots y arañas de Google necesitan ser capaces de crawlear tu sitio web (encontrarlo entre todo Internet) para poder recomendarlo en un resultado de búsqueda.

Un ejemplo típico es imaginarnos que Google es un librero en busca de un libro para recomendárselo a un cliente. Si no encuentra el libro, no podrá recomendarlo.

¿Y en qué se diferencia de la indexación?

En algún momento los robots de Google (Googlebots) serán capaces de encontrar tu contenido. Si lo hacen, querrán indexarlo en el buscador. Como si fuera una librería, los robots quieren conocer la naturaleza de la información para poder categorizarla y recomendarla a los usuarios que realicen búsquedas relacionadas con ese contenido.

Si tu libro es anónimo o no tiene título, ¿puedes archivarlo bien? Si Google no puede leer correctamente tu contenido y prepararlo para quien lo quiera ver, no será atractivo para los usuarios, por lo que poco a poco dejarán de utilizar el buscador si pasan a creer que no responde a sus necesidades.

Vale… y ahora vamos al turrón.

¿Cómo puedo indexar mi sitio en Google?

Una vez que creamos un sitio web, tenemos que cercionarnos que cada uno de los contenidos que hemos creado son indexados en el buscador, de lo contrario difícilmente obtendremos los resultados que esperamos.

Lógicamente, tendremos que revisar aquellas URLs destinadas a obtener tráfico, habrá muchas otras que quizá ni siquiera nos interese mostrárselas, como puede ser la página de login, etc…

URLs candidatas a ser indexadas

De primeras, las URLs de nuestro sitio deben cumplir ciertos requisitos:

- No estar bloqueadas por meta robots o en cabecera a través de x-robots.

- No estar canonicalizada

- Código de respuesta 200 (a veces se indexan URLs con otros códigos, pero suele ser temporal)

- Contenido útil

- Rastreable

Tracking de la web con Google Analytics

¿Qué tal si damos de alta el sitio web en Google Analytics?

Esta es la forma básica de irle informando de las URLs de las que se compone mi sitio, ya que las irá trackeando en función de la navegación de los usuarios, aunque no es inicialmente garantía de indexación de ningún tipo.

Subir o resubir el Sitemap XML

Podemos generar un fichero XML con todas las URLs que nos gustaría trabajar y enviárselo a Google a través de Google Search Console (GSC).

Si ya tenemos el sitemap creado, podemos resubirlo actualizado con las nuevas URLs que deseamos indexar.

Podremos controlar el nivel de saturación, es decir, el número de URLs indexadas en relación con el número de URLs enviadas a Google.

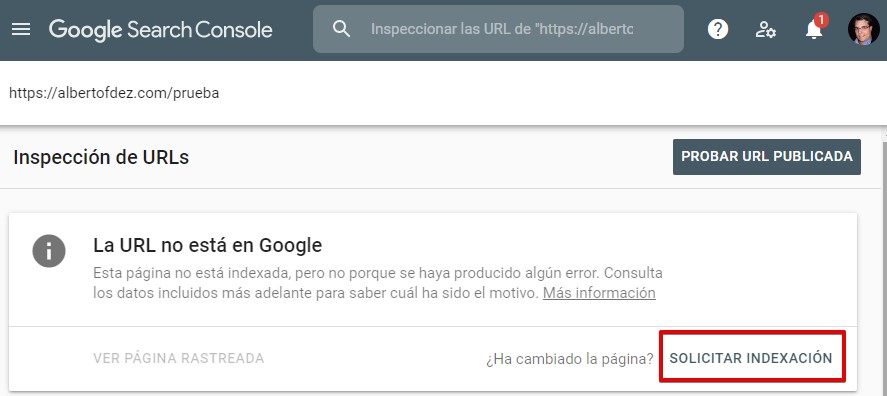

Explorar como Google

Dentro de GSC del propio buscador, tenemos la opción de solicitar a Google que explore alguna de nuestras URLs y una vez lo haya hecho, enviársela a sus índices.

GSC -> Inspeccionar URL de…

Para posteriormente solicitar indexación directamente:

Antiguamente lo podíamos hacer 500 veces al mes si solamente queríamos que explorara una URL concreta, o 10 veces al mes si lo que deseábamos era que explorara esa URL y los enlaces que allí viera.

Durante un tiempo hemos podido enviar en mayor cantidad, pero desde finales de diciembre de 2020 (tras haber estado un tiempo sin poder utilizarse esta herramienta) podemos solicitar indexación de nuevo con ciertas limitaciones.

Colocar URL en el campo de Adwords Keyword Planner

Dentro del planificador de palabras clave, tenemos un sitio donde podemos indicarle una URL y que pruebe a decirnos términos relacionados en función del contenido que allí encuentre.

De este modo, procesará esa dirección web, lo que ayudará muy probablemente a que la reconozca y la indexe con anterioridad.

Añadir URL a los buscadores

El método clásico para hacerle llegar a los buscadores tu URL es utilizar las direcciones típicas que ellos mismos ponen a nuestra disposición. Repasemos los principales buscadores:

Aparecer en Google

Google, aunque no lo tenga ubicado en primera página (quizá porque ya no es ni necesario hacerlo), dispone de una URL donde explica todas las formas posibles de aparecer en Google.

Para ello, no tenemos más que visitar:

Seleccionaremos la opción que más nos interese en cada caso. Quizá para indexar una URL normal, en el 99,9% de los casos utilicemos Search Console, pero podemos trabajar sin problema con cualquiera de las demás herramientas. Recordar que para poder trabajar necesitaremos estar logueados en su plataforma.

Indexar URL en Bing y Yahoo

La interfaz del buscador Bing para enviar una URL era igual de sencilla que la de Google, y en septiembre de 2018 la dieron de baja por la baja calidad de las URLs enviadas. Para enviarlas ahora, podrá hacerse desde Bing Webmaster Tools.

Yahoo funciona con el mismo índice de Bing, por lo que al darlo de alta en Bing automáticamente tendremos nuestras URLs en Yahoo.

Puedes darte de alta aquí: https://www.bing.com/toolbox/webmaster

Indexar URL en Baidu

Para ello lo primero es darnos de alta en su herramienta para webmasters, verificar a través de SMS la cuenta y seguir los pasos para dar de alta tu sitio.

La URL de las tools de este buscador es la siguiente: https://passport.baidu.com/v2/?reg

Indexar URL en DuckDuckGo

Duck Duck Go no tiene un sitio en el que tu le puedas hacer llegar una URL. Al contrario que el resto de buscadores, indexa de forma automática todas las URLs que encuentra en más de 400 fuentes distintas, entre las que se encuentran sitios como Wikipedia y el buscador Bing, por lo que si lo has dado de alta como te he indicado anteriormente, en breve aparecerás. Desde Duck Duck Go indican que Google no es directamente una fuente de información. Curioso.

Envía tu publicación a Google My Business

Inicia sensión en GMB, crea un nuevo post del tipo What´s New, agrega una foto, escribe una descripción breve, selecciona Learn more para añadir un botón, coloca la URL que deseas indexar y publica. Repite el proceso con las URLs desde donde enlazas a esa URL. Lo que ocurrirá te sorprenderá… 😉

Utiliza la API de indexación de Google

¿No conocías que existe una API? Mira esto: https://developers.google.com/search/apis/indexing-api/v3/quickstart

Podremos notificar a Google de la existencia de una nueva URL, actualizarla, eliminarla y obtener su estado actual.

Compartir URL en redes sociales

Las redes sociales no son santo de mi devoción en el 90% de proyectos. Pero compartirlas y que los buscadores al rastrearlas las encuentren no está demás.

Por ello mi recomendación es realizar una estrategia, por lo menos básica, en cada red social y compartir el mensaje así como lo hayamos predispuesto. Serán links, y por tanto ayudarán a descubrir.

Además, desde hace algún tiempo, Google indexa algunos perfiles de Twitter, algunos tweets…

Añadir la URL a marcadores sociales

Los marcadores sociales no son fáciles, ni sencillos, ni un juego de niños. Si realmente queremos trabajarlos nos exigirá mucho tiempo, paciencia y trabajo a fondo perdido. Muchos no requieren nada, pero los que pueden darnos alegrías a nivel de tráfico, todo lo contrario.

Aún así, y como hablamos de indexación, es una ayuda más para conseguir llamar la atención de los buscadores y que las indexen.

Realizar buen linkbuilding interno

Si nuestro linkado interno es correcto, el usuario navega de una a otra página sin problemas y conseguimos buena retención en tiempo en la página de cada uno, será muy probable que para los robots también sea un estupendo parque de atracciones.

Podríamos tratar, por ejemplo, cada vez que creamos un contenido bueno, de crear un link en alguna página relacionada que tenga aproximadamente una visita diaria del robot que la cachea. Esto nos asegurará de que en 24 horas máximo el robot pasará por la nueva URL. Por este motivo, me gusta por ejemplo colocar en la página principal de un proyecto links a los cuatro últimos artículos o noticias. De esta forma me aseguro de que pase el robot, ya que por la página principal es por donde más suele pasar en un proyecto web correctamente estructurado.

Arquitectura compleja dificulta la indexación

Si tenemos una arquitectura demasiado compleja, puede ser que ciertos contenidos queden ocultos a los robots de los buscadores, y si no eres demasiado relevante y popular para ellos, en seguida se cansen de indagar, por lo que si tienes muchos niveles de anidación en tu grafo de arquitectura, nunca lleguen a los nodos finales.

Cuanto más plana sea tu arquitectura, más fácil será llegar por ejemplo a tu contenido. Esta es la forma más simple de estructurar pensando en la indexación.

Linkbuilding general

Nunca estará demás colocar links donde sepamos que el robot de google pasa cada muy poco tiempo, como pueden ser los periódicos o la sección más relevante para el buscador.

Una forma sencilla de saber esta información es mirar la sección de páginas relevantes de Webmaster Tools:

Tráfico de Búsqueda -> Consultas de Búsqueda -> Páginas Principales

Mantén una correcta navegación

Si conseguimos una navegación correcta en nuestro sitio web contribuiremos a una mayor incursión del robot a nivel de indexación, como hemos visto en el punto anterior. Conseguiremos que más rápidamente nuestro sitio sea indexado. Ya sabes, recuerda usar las migas de pan.

Genera contenido nuevo

Añadir de forma frecuente contenido de calidad a tu sitio atraerá a los robots cada vez más y con mayor frecuencia a tu sitio web. Conseguiremos que Google reindexe y vuelva a reindexar cada vez nuestro sitio, e irá dando importancia a cada una de sus páginas. Con la rutina, cada vez lo indexará hará antes en el tiempo.

Indexa tus posts usando Digg y Reddit

Digg es utilizado por muchísimos usuarios, principalmente en nichos de ciencia y tecnología. Es capaz de combinar en un mismo sitio la potencia de un marcador social, blogging y sindicación.

¿Alguna vez has trabajado Digg y Reddit para mejorar tu indexación web?

Reddit es una web de marcadores sociales, un agregador de noticias bastante conocido en el mundillo de internet. Su sistema de votaciones entre usuarios hará que tu noticia tenga mayor o menor visibilidad. Si escribes buen contenido atractivo para los usuarios, este es tu sitio.

Añadir nuestro enlace si lo consideramos oportuno, también ayudará a ser encontrado más fácilmente por los buscadores. Ambos servicios conseguirán que nuestro contenido coja fuerza y popularidad si es realmente bueno, y por tanto Google siempre estará atento.

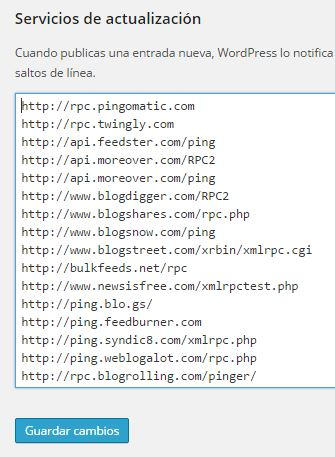

Ping a tu URL

No está demás avisar cuando generamos nuevo contenido, y no dar lugar a que se den cuenta o no. Lo cierto es que si tu sitio está sano, lo mejor es ver cómo se dan cuenta sin ser avisados. De vez en cuando intento no pingear para ver cuánto realmente tardan en percatarse. Si pasa de 24 horas tengo cierta preocupación.

Para los que usamos WordPress, plugins como Yoast te permiten al crear el Sitemap pingear a los principales buscadores como Google, Bing, Yahoo o Ask. Sin embargo, muchos no conocen otro apartadito donde podemos avisar a muchos más. Esto se encuentra en

Ajustes -> Escritura

URLs con un mínimo de trabajo OnPage

Hay ciertos factores onpage que deberíamos cuidar a la hora de trabajar las URLs de nuestro sitio web.

URLs amigables

Mantener nuestras URLs limpias y amigables ayudan no solo a los usuarios a entender el contenido interno sin ni siquiera hacer clic, también a los buscadores a interpretarla.

¿Sabes que trabajar las URLs amigables ayudará en tu indexación?

Parámetros de URLs

Si no lo sabéis, en las Webmaster Tools de Google

Rastreo -> Parámetros de URL

podemos trabajar cada uno de los parámetros que utilizamos en nuestro sitio web, informando a Google de:

- ¿qué sentido o efecto tiene ese parámetro?

- ¿cambia el contenido que se muestra al usuario?

- ¿cómo influye si lo cambia?

- ¿qué debería de hacer Google si lo encuentra?

Sobre todo en proyectos como E-commerce se utilizan gran cantidad de parámetros de control. No queremos que se indexen en los buscadores la misma URL con y sin parámetros añadidos. O quizá en algún caso pueda sernos interesante, por ejemplo si trabajamos las búsquedas (si no corremos el riesgo de que nos pase como a la SGAE y lo controlamos bien)

Si el buscador nos ha indexado más URLs de las que realmente tiene nuestro sitio web, en la mayoría de los casos es debido al mal trabajo de los parámetros en las URLs. Esto lo podemos observar al revisar el nivel de saturación, es decir, la cantidad de páginas indexadas frente a las enviadas en el Sitemap de tu sitio web.

Código limpio

No es lo mismo para los robots encontrarse un código fuente limpio y cuidado, que el típico código espaguetti. Para mí no es vital, pero es interesante intentar tener el mínimo de errores según la W3C. Esto podemos verlo en el validador de la W3C:

o en herramientas como Woorank que la integran.

Alta en directorios

El alta en directorios se ha “prostituido” bastante en los últimos años, y ha llegado a extremos en los que muchos compañeros SEOs han decidido dejar de trabajarlos. Creo que esto es un error, dado que muchos directorios todavía pueden ayudarnos, entre otras cosas, a mejorar la indexación de nuestro sitio web.

Mira estos criterios de calidad para el alta en directorios de tu web

A mí me gusta trabajarlos siguiendo unos estrictos criterios de calidad:

- DA de la Home (Domain Authority)

- DA de las categorías que vaya a trabajar

- Políticas claras de inclusión

- Que no me exijan un enlace recíproco

- Que el enlace no implique hacer redirecciones

- El valor de Trust de Majestic

- Alexa Rank

- Tráfico Semrush

- Señales sociales: followers, suscriptores, comentarios, +1…

- Elementos onpage trabajados

- Frescura de contenidos: fechas de publicación, actualidad, publicaciones/mes…

En definitiva, lo que le pediría a cualquier otro enlace a mi sitio web.

Guess posting en sitios estratégicos

Los artículos como invitados puede ser una estupenda estrategia para poner un enlace en un sitio web importante, al que Google adore. Esto hará que salte con mayor frecuencia a nuestro sitio web.

Por tanto, es una buena estrategia indirecta para mejorar la indexación en nuestra web.

Y ahora, ¿conoces algún otro método interesante para ayudar a indexar URLs en Google? ¿Conoces otro método para tener un 100% de indexación? Si quieres lo comentamos en los comentarios 😉

Mejoras en los datos de cobertura de la indexación

El 11 de enero de 2021 Google anunció ciertas mejoras en la información que nos proporciona sobre la indexación de las URLs de nuestro sitio web:

- Eliminó el famoso mensaje genérico de “anomalía de rastreo”.

- Las URLs bloqueadas por robots.txt pero que se enviaron e indexaron aparecen como “indexadas pero bloqueadas” y en grado de advertencia en vez de error.

- Se generó un nuevo aviso de advertencia para las URLs indexadas sin contenido.

- Se amplió la información para los errores 404 leves.