Post anterior

23 formas de Indexar URLs en GooglePor mucho que nos esforcemos en trabajar el posicionamiento de nuestro sitio web, y conseguir más y más tráfico, uno de los problemas más graves que existen es que no tenemos el 100% de nuestro sitio web bien indexado en los buscadores.

Por tanto, si no hemos indexado, es poco probable que nos llegue tráfico orgánico verdad? Pues por esta razón yo me lo tomo casi como algo personal.

Y como vimos en el post anterior sobre un montón de formas de indexar una URL en Google, luego tendremos que comprobar que cada una de ellas realmente se indexa.

¿Cómo puedo saber si mi URL está indexada?

La forma más simple de saber si una URL está indexada es realizar una consulta en el buscador similar a esta:

site:albertofdez.com/mi-url

Esto ya lo hemos visto en mil sitios, y está bien cuando quieres mirar alguna cosilla puntual. Sin embargo, para los que nos dedicamos a esto, ¿no os vendría mejor checkear al completo todas las URLs de un sitio web? Algo así como pasarle Screaming Frog e ir chequeando una a una cada una de las URLs en HTML que tiene el sitio, y que automáticamente nos apareciera si está indexada o no.

WMT podría mejorar un poco e informarnos de qué URLs tenemos o no tenemos indexadas, en vez de quedarse solamente en el dato, el número de cuántas de ellas lo están.

Pues esto es lo que he intentado hacer y vamos a ver algunas posibilidades para conseguirlo…

Consejo MJ en el Congreso SEO Online

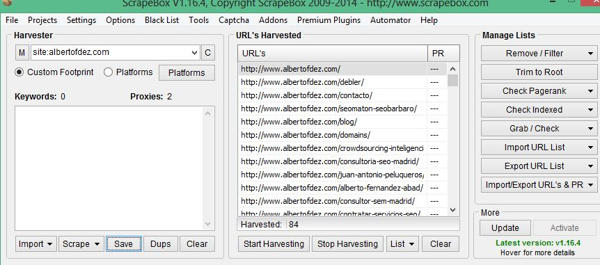

Charlando con MJ Cachón en el turno de preguntas de su ponencia en el Congreso SEO Profesional, comentaba la posibilidad de hacerlo cruzando el conjunto de URLs de tu sitio web (sacado con herramientas como Screaming Frog) con el informe que sacaran herramientas como Scrapebox al realizar una búsqueda con comando, como podéis ver en la imagen.

Del mismo modo, Scrapebox tiene una opción para checkear la indexación de un conjunto de URLs (Check Indexed) que nosotros introdujéramos, aunque nunca he conseguido que funcione al 100%.

Control de indexación masiva usando Google Spreadsheet

Mi experiencia con Spreadsheet es de amor-odio. Me encanta, me parece la leche, pero falla más que una escopeta de feria a la vez de que es muchísimo más lenta que cualquier Excel.

Sin embargo, me permite hacer cosas que con Excel jamás podría, ni aún instalándole montones de SEO Tools.

La clave de todo está en la fórmula ImportXML, capaz de encontrar algo en el código fuente de una URL. Según esto, podríamos tratar de investigar la diferencia entre la URL de Google.es cuando se realiza una búsqueda con el comando site de una URL determinada, cuando la encuentra y cuando no.

El Bulk Check Index

Vale, pues ahora vamos a ver cómo lo construiríamos.

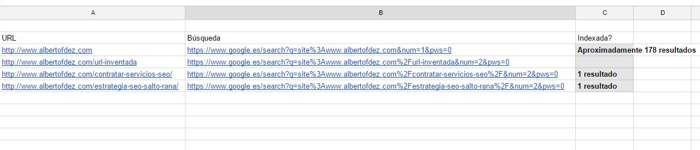

Lo primero crearnos un nuevo documento de Spreadsheet, en el que incluiríamos todas y cada una de las URLs del sitio web que quisiéramos revisar. Por ejemplo, en la columna A a la que llamaremos en cabecera “URL”.

A continuación, trabajaríamos una simple y sencilla concatenación de la URL que Google genera al realizar la búsqueda del comando “site:miurl.com” con algún parámetro de control (aunque no son necesarios) como num=1 o pws=0. Esto por ejemplo en la columna B bajo el encabezado de “Búsqueda”.

Por último, nuestro comprobador en la columna C bajo el encabezado de “¿Indexada?”:

[notification type=”alert-success” close=”false” ]ImportXML(B3;“//div[@id=’resultStats’]”)[/notification]

o mejor este… usando info: en vez de site:

[notification type=”alert-success” close=”false” ]REGEXREPLACE(importxml(“http://www.google.com/search?q=”&info:https://albertofdez.com“//div[@id=’resultStats’]”);“.*?([0-9,]+) results?”;“$1”)[/notification]

El resultado de esta fórmula será vacío si no la encuentra, y en su defecto aparecerán N resultados. Cuando aparece algún resultado es que está indexada. Si aparecen varios, es porque Google muestra todas las URLs indexadas y que a nivel de “arquitectura” tiran de esa misma URL.

Nuestro Spreadsheet quedaría similar a este:

Bulk Check Index… ¿sabrías cómo hacerlo?

Control de indexación masivo con URL Profiler

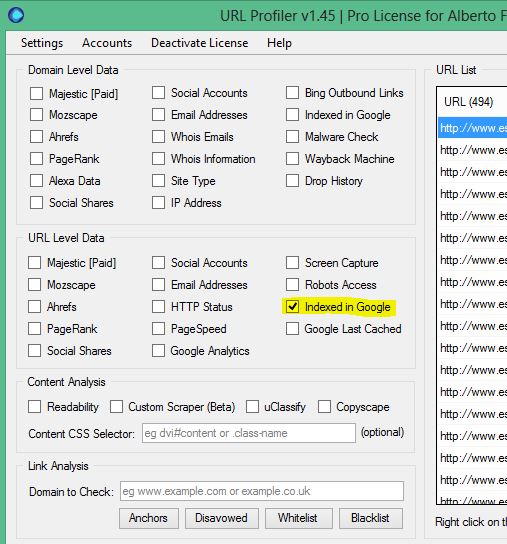

Actualizando este post siguiendo el comentario de MJ, os pongo aquí mis pruebas y el magnífico resultado usando esta herramienta. URL Profiler tiene un coste mensual de 12,95 libras al mes. Además, tendríamos que sumarle la compra de algunos proxys, que podéis hacerlo desde aquí

Una vez introducidos los proxies en las opciones de configuración, tenemos que seleccionar las opciones que nos interesan. En este caso, vamos a seleccionar lo relativo a la indexación en Google.

Para añadir todas y cada una de las URLs del sitio web no hemos echo más que utilizar el programa Screaming Frog, filtrar por HTML, copiar las direcciones web y pegarlas con botón derecho en este programa.

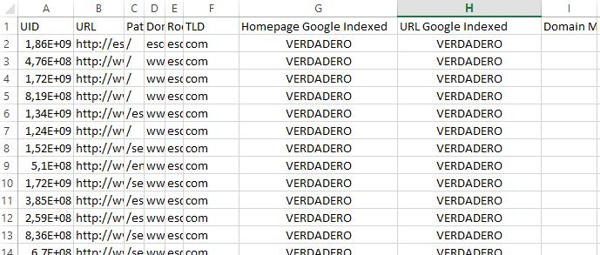

Una vez que lo iniciamos marcando la opción “Run Profiler” nos genera un informe similar al que aparece en la siguiente imagen.

Como veis, aparece en una columna con el encabezado URL Google Indexed un valor verdadero o falso en el caso de que esté indexada o no lo esté.

El único problema que le veo, y por lo que estoy intentando contactar con soporte, es que yo quiero saber si está indexada en Google.es, y mu probablemente las comprobaciones me las esté realizando el Google.com.

Os mantendré informados 😉

¿Conocéis vosotros alguna herramienta que haga esta función o lo realizáis de alguna otra manera? Formas hay muchas, y en ocasiones tenemos que sacarnos las castañas para intentar ahorrar tiempos en algo tan simple y a la vez relevante como esto.